Navigation menu

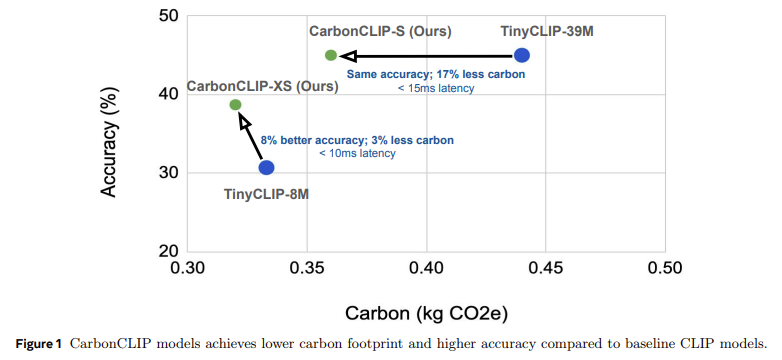

IT HOME 5月15日新闻,技术媒体Marktechpost昨天(5月14日)发布了一篇博客文章,报道说,Meta AI的Fair Team在佐治亚技术学院的手中共同努力,共同努力,以建立Catransformers框架,以碳释放为设计的基本设计,并进行大量减少模型。机器学习技术的普及已促进了从推荐系统到自主驾驶的创新,但是环境成本无法被估计。这些系统需要强大的计算资源,并且通常依靠自定义的硬件加速器来运行。训练和理解阶段期间的高能量消耗直接导致CA泄漏的增加。此外,从制造到刮擦的整个硬件生命周期也产生了“隐性碳”,从而增加了生态负担。随着世界各地的行业加速采用AI技术,解决操作的双重资源和碳隐式已经存在迫切需要。当前减少排放方法的重点是提高运行效率,例如优化培训和推理的能源消耗或改善硬件使用。但是这些方法通常会忽略硬件设计和制造阶段的碳泄漏,并且不会不包括模型设计和硬件效率的相互影响。 Meta的Fair Team和Georgia Tech的Catransformers Framework在Pagsconsed的基本设计中进行了碳泄漏。该框架通过多功能贝叶斯优化引擎,延迟平衡,能耗,准确性和总碳跟踪结合了模型和硬件加速器的建筑性能。特别是对于侧推理设备,Catransformers通过促进大型剪辑模型并研究碳泄漏和性能以及硬件估算工具来形成变体。它的结果是CarbonClip-S,在TinyClip-39m中具有相似的精度,但其碳泄漏降低了17%,THE延迟在15毫秒内得到控制;与TinyClip-8M相比,CarbonClip-XS提高了8%,碳发行量降低了3%,延迟小于10毫秒。研究表明,优化延迟的设计可能会导致碳隐含的增加高达2.4倍,而全面优化碳泄漏和延迟的技术可以实现19-20%释放的总释放,而延迟的延迟很小。 Catransformers通过环境指标的宝石为机器研究系统的可持续设计奠定了基础。它表明,如果AI开发从一开始就结合了硬件功能和对碳影响的考虑,它将达到双赢的性能和维护状况。随着AI规模的不断扩大,该框架为行业提供了减少排放的可行途径。参考参考有房子

IT HOME 5月15日新闻,技术媒体Marktechpost昨天(5月14日)发布了一篇博客文章,报道说,Meta AI的Fair Team在佐治亚技术学院的手中共同努力,共同努力,以建立Catransformers框架,以碳释放为设计的基本设计,并进行大量减少模型。机器学习技术的普及已促进了从推荐系统到自主驾驶的创新,但是环境成本无法被估计。这些系统需要强大的计算资源,并且通常依靠自定义的硬件加速器来运行。训练和理解阶段期间的高能量消耗直接导致CA泄漏的增加。此外,从制造到刮擦的整个硬件生命周期也产生了“隐性碳”,从而增加了生态负担。随着世界各地的行业加速采用AI技术,解决操作的双重资源和碳隐式已经存在迫切需要。当前减少排放方法的重点是提高运行效率,例如优化培训和推理的能源消耗或改善硬件使用。但是这些方法通常会忽略硬件设计和制造阶段的碳泄漏,并且不会不包括模型设计和硬件效率的相互影响。 Meta的Fair Team和Georgia Tech的Catransformers Framework在Pagsconsed的基本设计中进行了碳泄漏。该框架通过多功能贝叶斯优化引擎,延迟平衡,能耗,准确性和总碳跟踪结合了模型和硬件加速器的建筑性能。特别是对于侧推理设备,Catransformers通过促进大型剪辑模型并研究碳泄漏和性能以及硬件估算工具来形成变体。它的结果是CarbonClip-S,在TinyClip-39m中具有相似的精度,但其碳泄漏降低了17%,THE延迟在15毫秒内得到控制;与TinyClip-8M相比,CarbonClip-XS提高了8%,碳发行量降低了3%,延迟小于10毫秒。研究表明,优化延迟的设计可能会导致碳隐含的增加高达2.4倍,而全面优化碳泄漏和延迟的技术可以实现19-20%释放的总释放,而延迟的延迟很小。 Catransformers通过环境指标的宝石为机器研究系统的可持续设计奠定了基础。它表明,如果AI开发从一开始就结合了硬件功能和对碳影响的考虑,它将达到双赢的性能和维护状况。随着AI规模的不断扩大,该框架为行业提供了减少排放的可行途径。参考参考有房子